22.01.13 텐서플로우와 딥러닝

2022. 1. 13. 22:00ㆍ작업/머신러닝

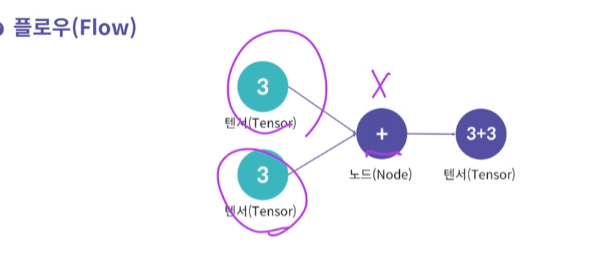

텐서 : 다차원 배열

플로우 : 데이터의 흐름

텐서플로우 version1은 그래프 및 세션 생성이 필요했다.

텐서플로우 version2는 즉시실행이 가능해서 계산그래프, 세션 생성 없이 실행이 가능하다.

텐서 데이터 생성(numpy와 비슷하게 상수,시퀀스,난수,변수 등을 텐서형으로 생성하는 연산..)

텐서플로우로 딥러닝 모델 구현하기

- 데이터셋 준비하기

- 딥러닝 모델 구축하기

- 모델 학습시키기

- 평가 및 예측

epoch : 한번 학습을 완료한 상태

batch : 나눠진 데이터 셋

iteration : epoch를 나누어서 실행하는 횟수를 의미

import tensorflow as tf

import matplotlib.pyplot as plt

import matplotlib as mpl

import numpy as np

import os

os.environ['TF_CPP_MIN_LOG_LEVEL'] = '2'

from elice_utils import EliceUtils

elice_utils = EliceUtils()

np.random.seed(100)

'''

1. 선형 회귀 모델의 클래스를 구현합니다.

Step01. 가중치 초기값을 1.5의 값을 가진 변수 텐서로 설정하세요.

Step02. Bias 초기값을 1.5의 값을 가진 변수 텐서로 설정하세요.

Step03. W, X, b를 사용해 선형 모델을 구현하세요.

'''

class LinearModel:

def __init__(self):

self.W = tf.Variable(1.5)

self.b = tf.Variable(1.5)

def __call__(self, X, Y):

return tf.add(tf.multiply(X,self.W), self.b)

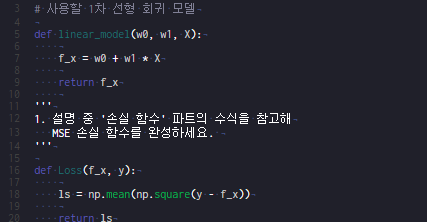

'''

2. MSE 값을 계산해 반환하는 손실 함수를 완성합니다.

'''

def loss(y, pred):

return tf.reduce_mean(tf.square(y - pred))

'''

3. gradient descent 방식으로 학습하는 train 함수입니다.

코드를 보면서 어떤 방식으로 W(가중치)와 b(Bias)이

업데이트 되는지 확인해 보세요.

'''

def train(linear_model, x, y):

with tf.GradientTape() as t: # 연산에 대한 기록들을 저장

current_loss = loss(y, linear_model(x, y))

# learning_rate 값 선언

learning_rate = 0.001

# gradient 값 계산

delta_W, delta_b = t.gradient(current_loss, [linear_model.W, linear_model.b])

# learning rate와 계산한 gradient 값을 이용하여 업데이트할 파라미터 변화 값 계산

W_update = (learning_rate * delta_W)

b_update = (learning_rate * delta_b)

return W_update,b_update

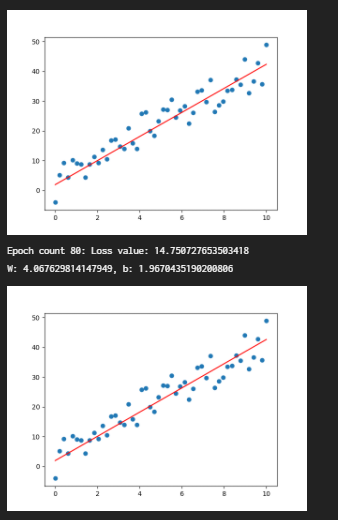

def main():

# 데이터 생성

x_data = np.linspace(0, 10, 50)

y_data = 4 * x_data + np.random.randn(*x_data.shape)*4 + 3

# 데이터 출력

plt.scatter(x_data,y_data)

plt.savefig('data.png')

elice_utils.send_image('data.png')

# 선형 함수 적용

linear_model = LinearModel()

# epochs 값 선언

epochs = 100

# epoch 값만큼 모델 학습

for epoch_count in range(epochs):

# 선형 모델의 예측 값 저장

y_pred_data=linear_model(x_data, y_data)

# 예측 값과 실제 데이터 값과의 loss 함수 값 저장

real_loss = loss(y_data, linear_model(x_data, y_data))

# 현재의 선형 모델을 사용하여 loss 값을 줄이는 새로운 파라미터로 갱신할 파라미터 변화 값을 계산

update_W, update_b = train(linear_model, x_data, y_data)

# 선형 모델의 가중치와 Bias를 업데이트합니다.

linear_model.W.assign_sub(update_W)

linear_model.b.assign_sub(update_b)

# 20번 마다 출력 (조건문 변경 가능)

if (epoch_count%20==0):

print(f"Epoch count {epoch_count}: Loss value: {real_loss.numpy()}")

print('W: {}, b: {}'.format(linear_model.W.numpy(), linear_model.b.numpy()))

fig = plt.figure()

ax1 = fig.add_subplot(111)

ax1.scatter(x_data,y_data)

ax1.plot(x_data,y_pred_data, color='red')

plt.savefig('prediction.png')

elice_utils.send_image('prediction.png')

if __name__ == "__main__":

main()

import tensorflow as tf

import numpy as np

from visual import *

import os

os.environ['TF_CPP_MIN_LOG_LEVEL'] = '2'

np.random.seed(100)

tf.random.set_seed(100)

def main():

# 비선형 데이터 생성

x_data = np.linspace(0, 10, 100)

y_data = 1.5 * x_data**2 -12 * x_data + np.random.randn(*x_data.shape)*2 + 0.5

'''

1. 다층 퍼셉트론 모델을 만듭니다.

'''

model = tf.keras.models.Sequential([

tf.keras.layers.Dense(20,input_dim=1,activation='relu'), # hidden node갯수 20개

tf.keras.layers.Dense(20,activation='relu'),

tf.keras.layers.Dense(1)

])

'''

2. 모델 학습 방법을 설정합니다.

'''

model.compile(loss = 'mean_squared_error', optimizer = 'adam')

'''

3. 모델을 학습시킵니다.

'''

history = model.fit(x_data, y_data, epochs=500, verbose=2) # verbose 어떻게 출력할건지 0은 출력이 안된다.

'''

4. 학습된 모델을 사용하여 예측값 생성 및 저장

'''

predictions = model.predict(x_data)

Visualize(x_data, y_data, predictions)

return history, model

if __name__ == '__main__':

main()

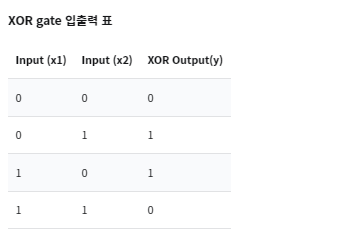

XOR 문제 해결

import numpy as np

import tensorflow as tf

from tensorflow.keras import layers

import os

os.environ['TF_CPP_MIN_LOG_LEVEL'] = '2'

def main():

# XOR 문제를 위한 데이터 생성

training_data = np.array([[0,0],[0,1],[1,0],[1,1]], "float32")

target_data = np.array([[0],[1],[1],[0]], "float32")

'''

1. 다층 퍼셉트론 모델을 생성합니다.

'''

model = tf.keras.Sequential()

model.add(tf.keras.layers.Dense(32, input_dim=2, activation='relu'))

model.add(tf.keras.layers.Dense(32, activation='relu'))

model.add(tf.keras.layers.Dense(1,activation='sigmoid'))

'''

2. 모델의 손실 함수, 최적화 방법, 평가 방법을 설정합니다.

'''

model.compile(loss='mse', optimizer='adam', metrics=['binary_accuracy'])

'''

3. 모델을 학습시킵니다. epochs를 자유롭게 설정해보세요.

'''

hist = model.fit(training_data, target_data, epochs=30)

score = hist.history['binary_accuracy'][-1]

print('최종 정확도: ', score*100, '%')

return hist

if __name__ == "__main__":

main()

'작업 > 머신러닝' 카테고리의 다른 글

| 22.01.15 딥러닝 학습의 문제점 (0) | 2022.01.16 |

|---|---|

| 22.01.14 드디어 프로젝트 배포 (0) | 2022.01.14 |

| 22.01.12 딥러닝 개론 (0) | 2022.01.12 |

| 21.12.19 모의테스트 (0) | 2021.12.19 |

| 21.12.18 나이브베이즈 분류 (0) | 2021.12.19 |